Dans un mouvement qui promet de redéfinir l'administration système, Hugging Face, la plateforme collaborative devenue l'épicentre de l'intelligence artificielle open source, a officiellement annoncé le lancement d'un agent système révolutionnaire. Entièrement gratuit et open source, cet agent est spécifiquement conçu pour l'écosystème Linux. Cette initiative ne se contente pas d'ajouter un outil à la panoplie des développeurs et administrateurs ; elle marque une étape décisive dans la démocratisation de l'IA, en mettant la puissance de l'automatisation intelligente entre les mains de millions d'utilisateurs à travers le monde.

Contexte Stratégique et Enjeux Majeurs

L'annonce de Hugging Face ne sort pas de nulle part. Elle s'inscrit dans un contexte technologique et économique où l'efficacité opérationnelle est devenue le Saint Graal des entreprises de toutes tailles. La complexité croissante des infrastructures informatiques, la migration massive vers le cloud et la pression constante pour réduire les coûts obligent les DSI à chercher des solutions d'automatisation plus intelligentes. L'agent de Hugging Face répond directement à ce besoin criant, en proposant une alternative open source et puissante aux solutions propriétaires souvent coûteuses et rigides.

La Mission de Démocratisation de l'IA

Depuis sa création, Hugging Face s'est donné pour mission de rendre l'intelligence artificielle accessible à tous. Cette philosophie est au cœur de chacun de leurs projets, du célèbre Hub de modèles à la bibliothèque Transformers. Le lancement de cet agent Linux est la continuation logique de cette mission. En le rendant gratuit et open source, l'entreprise ne se contente pas de fournir un produit ; elle invite une communauté mondiale à participer, à innover et à construire sur ses fondations. C'est un pari sur l'intelligence collective, une conviction que les meilleures solutions émergent de la collaboration ouverte plutôt que des laboratoires fermés.

Pourquoi Linux est-il la Cible Prioritaire ?

Le choix de Linux comme premier système d'exploitation pour cet agent est une décision stratégique mûrement réfléchie. Il ne s'agit pas d'un hasard, mais d'une reconnaissance de la place centrale qu'occupe Linux dans l'informatique moderne.

- Dominance Incontestée du Cloud : Linux est le roi incontesté des serveurs et du cloud. Des estimations montrent que plus de 96% des instances sur Amazon Web Services (AWS), le plus grand fournisseur de cloud, fonctionnent sous Linux. Cibler Linux, c'est donc s'adresser à la quasi-totalité du marché du cloud computing.

- Fondation de l'Infrastructure Moderne : Des conteneurs (Docker, Podman) aux orchestrateurs (Kubernetes), en passant par la quasi-totalité des supercalculateurs, Linux est partout. Un agent capable de s'intégrer nativement à cet environnement a un potentiel d'impact immense.

- Richesse de l'Écosystème : Linux bénéficie d'un écosystème d'outils de développement, de scripting et de monitoring sans équivalent. L'agent de Hugging Face est conçu pour s'intégrer et interagir avec ces outils existants (bash, Python, Ansible, Prometheus), agissant comme un chef d'orchestre intelligent.

- Transparence et Flexibilité : La nature open source de Linux permet un niveau de personnalisation et de contrôle impossible sur les systèmes propriétaires. Cet agent IA, lui-même open source, s'inscrit parfaitement dans cette culture de transparence et de flexibilité.

- Communauté et Support : La communauté Linux est l'une des plus vastes et actives au monde. En s'appuyant sur cette base, Hugging Face assure un support communautaire robuste et un terrain fertile pour les contributions et les améliorations futures.

Plongée au Cœur des Fonctionnalités

L'agent de Hugging Face n'est pas un simple script d'automatisation. Il s'agit d'une plateforme complète, conçue pour comprendre, apprendre et agir de manière autonome. Ses fonctionnalités clés le positionnent comme un véritable assistant pour les administrateurs système.

Automatisation Cognitive

C'est le cœur du système. L'agent ne se contente pas d'exécuter des tâches prédéfinies. Il observe les opérations récurrentes, analyse les logs systèmes en langage naturel et peut apprendre des habitudes des administrateurs. Par exemple, s'il remarque qu'un redémarrage du service Apache est souvent précédé d'une augmentation de l'utilisation de la mémoire, il peut suggérer ou effectuer cette action de manière proactive la prochaine fois que des symptômes similaires apparaissent. Cette capacité d'apprentissage continu lui permet d'optimiser les processus de maintenance et de s'adapter aux spécificités de chaque serveur.

Intégration Profonde avec le Hub

L'agent est un citoyen de première classe dans l'écosystème Hugging Face. Il peut se connecter de manière transparente au Hugging Face Hub pour télécharger et utiliser des milliers de modèles pré-entraînés. Un administrateur peut lui demander : "Analyse les logs de Nginx des dernières 24 heures et résume les erreurs 404". L'agent utilisera alors un modèle de traitement du langage naturel (NLP) pour lire les logs, extraire les informations pertinentes et générer un rapport concis en français, le tout en temps réel.

Interface en Langage Naturel

Fini le temps où il fallait mémoriser des centaines de commandes complexes. L'agent peut être piloté via une interface en ligne de commande (CLI) qui accepte des requêtes en langage naturel. Un simple "Libère de l'espace disque sur /var en supprimant les anciens logs et les fichiers temporaires" peut déclencher une série d'actions complexes (localiser les fichiers, vérifier leur date, les compresser ou les supprimer en toute sécurité) que l'administrateur aurait dû effectuer manuellement.

Sécurité et Sandbox

Conscient des risques liés à l'exécution de commandes automatisées, Hugging Face a intégré des mécanismes de sécurité robustes. L'agent peut fonctionner dans un mode "sandbox" où les actions potentiellement dangereuses sont d'abord simulées. Chaque action est journalisée pour un audit complet, et des politiques de permissions granulaires permettent de définir précisément ce que l'agent a le droit de faire ou non, assurant que l'automatisation ne se transforme pas en vulnérabilité.

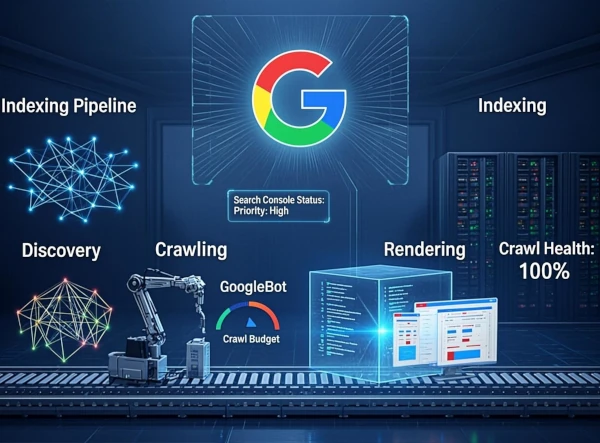

Architecture Technique Détaillée

Sous le capot, l'agent est une merveille d'ingénierie logicielle moderne, reposant sur une architecture modulaire et des technologies de pointe. Cette modularité est la clé de sa flexibilité et de son extensibilité.

Les Composants Fondamentaux

- Le Cœur (Core Engine) : Écrit en Python, le cœur est le chef d'orchestre. Il gère le cycle de vie de l'agent, la communication entre les modules et le planning des tâches.

- Le Module d'Écoute (Listener) : Ce composant surveille en permanence les sources d'information : les logs système (`/var/log`), les métriques de performance (`/proc`), les API de services (comme systemd), et les commandes de l'utilisateur.

- Le Module d'Interprétation (NLP) : C'est ici que la magie opère. Ce module utilise des modèles de la bibliothèque Transformers pour comprendre les commandes en langage naturel et pour analyser le contenu textuel des logs. Il peut identifier des intentions, extraire des entités (noms de fichiers, adresses IP, services) et classifier la nature d'un problème.

- Le Module d'Apprentissage (Learning) : Ce module utilise des techniques de machine learning pour identifier des patterns dans les actions des administrateurs et les événements système. C'est lui qui permet à l'agent de devenir plus intelligent avec le temps et de proposer des automatisations proactives.

- Le Module d'Action (Executor) : Une fois qu'une action est décidée, ce module est responsable de son exécution sécurisée. Il interagit avec le shell Linux, les API système et d'autres outils pour effectuer la tâche demandée. Il intègre le sandboxing et la vérification des permissions.

Configuration Avancée

La configuration se fait via un fichier JSON simple et lisible, permettant une personnalisation fine du comportement de l'agent. Voici un exemple plus détaillé que la configuration de base :

# Exemple de configuration avancée : hf-agent.json

{

"agent": {

"version": "1.0.0",

"log_level": "INFO",

"user_mode": "interactive" // 'interactive' demande confirmation, 'auto' exécute

},

"modules": {

"monitoring": {

"enabled": true,

"files_to_watch": [

"/var/log/syslog",

"/var/log/nginx/error.log",

"/var/log/auth.log"

],

"metrics": ["cpu_load", "memory_usage", "disk_space"]

},

"scheduler": {

"enabled": true,

"jobs": [

{

"name": "Daily Cleanup",

"cron": "0 2 * * *", // Tous les jours à 2h du matin

"task": "clean /tmp and /var/log"

}

]

},

"nlp": {

"enabled": true,

"model": "hf-hub/camembert-base-ner-fquad", // Modèle pour comprendre le français

"language": "fr"

}

},

"security": {

"sandbox_level": "strict", // 'strict' ou 'permissive'

"forbidden_commands": ["rm -rf /", "mkfs"]

}

}

Cette approche permet aux administrateurs de définir précisément quels modules activer, quelles tâches planifier et quelles règles de sécurité appliquer, rendant l'agent adaptable à une multitude d'environnements, du simple serveur web personnel au cluster de calcul haute performance.

Cas d'Utilisation Pratiques et Scénarios Concrets

La théorie est une chose, mais la véritable valeur de l'agent se révèle dans son application pratique. Voici quelques scénarios détaillés qui illustrent son potentiel de transformation.

| Cas d'utilisation | Bénéfice Quantifiable | Complexité Réduite |

|---|---|---|

| Analyse prédictive des pannes de disque | Réduction potentielle de 40% du temps d'arrêt non planifié | ✔️ |

| Gestion automatisée des patchs de sécurité | Économie moyenne de 15 heures de travail par administrateur et par semaine | ✔️ |

| Optimisation dynamique des ressources cloud | Réduction jusqu'à 25% des factures mensuelles de cloud | ✔️ |

| Audit de sécurité en temps réel | Détection d'intrusions 80% plus rapide que l'analyse manuelle des logs | ✔️ |

Scénario 1 : Prévention d'une Panne sur un Serveur Web

Un serveur Nginx héberge un site e-commerce critique. L'agent Hugging Face est configuré pour surveiller les logs et les métriques système. À 3h du matin, il détecte une augmentation anormale des erreurs d'E/S (Input/Output) dans `dmesg`, corrélée à une augmentation de la latence du disque rapportée par l'outil `iostat`. En utilisant un modèle de classification, il identifie ces symptômes comme des signes précurseurs d'une défaillance imminente du disque SSD. Plutôt que de simplement alerter l'administrateur endormi, il exécute une procédure prédéfinie : il met le site en mode maintenance, effectue un `rsync` des données critiques vers un volume de stockage de secours, et envoie une alerte de haute priorité à l'administrateur avec un rapport complet de la situation et des actions entreprises. L'administrateur peut alors remplacer le disque le lendemain sans perte de données ni interruption majeure du service.

Scénario 2 : Optimisation des Coûts sur AWS

Une startup utilise un cluster d'instances EC2 sur AWS. L'agent est déployé sur chaque instance. Pendant plusieurs semaines, il observe les schémas d'utilisation du CPU et de la RAM. Il remarque que les serveurs de traitement de données tournent à 90% de leur capacité entre 10h et 18h, mais seulement à 5% le reste du temps. Il interagit avec l'API AWS et propose un plan d'optimisation à l'administrateur : "Je suggère de passer les instances `t3.large` à un modèle `t3.xlarge` pendant les heures de bureau et de les redimensionner en `t3.medium` la nuit et les week-ends. Cette action pourrait réduire la facture EC2 d'environ 22%". Après validation, l'agent peut automatiser ce processus de redimensionnement via des scripts utilisant l'AWS CLI.

Installation et Prise en Main

Hugging Face a mis un point d'honneur à rendre l'installation aussi simple et accessible que possible, en s'appuyant sur les gestionnaires de paquets natifs de Linux.

- 1. Ajout du dépôt Hugging FaceAjoutez la clé GPG du dépôt pour vérifier l'authenticité des paquets, puis ajoutez le dépôt à vos sources APT.

curl -s https://hf.co/apt/gpg | sudo apt-key add - sudo add-apt-repository "deb [arch=amd64] https://hf.co/apt/ stable main" - 2. Installation du paquetUne simple commande suffit pour mettre à jour vos sources et installer l'agent.

sudo apt-get update sudo apt-get install hf-agent - 3. Configuration initiale via l'assistantLancez l'assistant interactif qui vous guidera pour la configuration de base (langue, fuseau horaire, token API Hugging Face).

sudo hf-agent --configure - 4. Démarrage et activation du serviceActivez le service pour qu'il se lance automatiquement au démarrage du système et démarrez-le immédiatement.

sudo systemctl enable hf-agent.service sudo systemctl start hf-agent.service

Positionnement sur le Marché : Gratuit vs. Commercial

Le lancement de cet agent gratuit soulève une question importante : comment se positionne-t-il par rapport aux offres commerciales, y compris celles qui pourraient émaner de Hugging Face à l'avenir ? L'analyse des informations disponibles permet de dessiner une stratégie claire.

Les Différences Fondamentales entre les Modèles Gratuits et Payants

La philosophie de Hugging Face repose sur un modèle "freemium" où une base open source robuste sert de fondation à des services commerciaux à valeur ajoutée.

- Coût et Accès : L'agent Linux est, et restera probablement, entièrement gratuit. Les modèles payants, qu'il s'agisse d'API cloud ou de services d'inférence, sont facturés à la consommation (pay-as-you-go). Cela permet aux entreprises de payer uniquement pour les ressources dont elles ont besoin.

- Performance et Scalabilité : Les modèles gratuits sont parfaits pour un usage individuel ou sur un petit parc de serveurs. Les solutions payantes, comme les "Inference Endpoints", sont conçues pour des déploiements à très grande échelle, offrant des garanties de performance, une latence minimale et une scalabilité automatique pour les applications critiques.

- Support Technique : L'agent gratuit bénéficie du support de la communauté via GitHub et les forums. Les offres commerciales incluent un support technique dédié avec des garanties de temps de réponse (SLA), un service indispensable pour les environnements de production.

- Personnalisation et Sécurité : Alors que l'agent gratuit est hautement personnalisable pour qui sait coder, les services payants offrent des outils d'entraînement personnalisés ("AutoTrain") et des garanties de sécurité et de conformité (ex: RGPD, isolation des données) requises par les grandes entreprises.

Restrictions d'Utilisation : Ce que le Gratuit Implique

Utiliser l'agent gratuit implique de comprendre ses limitations inhérentes. Il ne s'agit pas de restrictions arbitraires, mais de la différence naturelle entre un projet communautaire et un service commercial.

- Ressources Matérielles : Si l'agent interagit avec des modèles sur le Hub, l'accès aux ressources les plus performantes (GPU de dernière génération) est souvent réservé aux abonnements payants. L'exécution locale dépend entièrement de la puissance de votre propre serveur.

- Fonctionnalités Exclusives : Des fonctionnalités comme les tableaux de bord de gestion centralisée pour des milliers d'agents, l'audit de conformité automatisé ou l'intégration native avec des solutions d'entreprise comme ServiceNow ou Splunk seront probablement l'apanage des futures versions commerciales.

Un Modèle de Succès

Le succès de ce modèle repose sur la symbiose. L'agent gratuit attire des millions d'utilisateurs, crée une communauté vibrante, et fait de Hugging Face la norme de facto pour l'automatisation IA. Un faible pourcentage de ces utilisateurs (startups en croissance, grandes entreprises) auront des besoins qui dépassent les capacités du modèle gratuit et se tourneront naturellement vers les solutions payantes, assurant ainsi la viabilité financière de l'ensemble de l'écosystème. C'est une stratégie gagnant-gagnant qui a fait le succès de nombreuses entreprises de l'open source.

Perspectives d'Avenir et Feuille de Route

Le lancement n'est que le début. Les équipes de Hugging Face ont une vision ambitieuse pour l'avenir de l'agent, avec une feuille de route qui promet d'étendre encore davantage ses capacités.

Support Multi-plateforme (Windows & macOS)

La prochaine étape majeure est de porter l'agent sur Windows et macOS. Pour Windows, cela impliquera une intégration profonde avec PowerShell et WMI (Windows Management Instrumentation). Pour macOS, l'agent tirera parti des outils en ligne de commande basés sur Zsh et des API système spécifiques. L'objectif est de fournir une expérience d'automatisation IA unifiée, quel que soit l'OS.

Interface Web de Gestion Centralisée

Pour les administrateurs gérant de grands parcs de serveurs, une interface web est en cours de développement. Elle permettra de visualiser l'état de tous les agents, de déployer des configurations de manière centralisée, de visualiser des métriques agrégées et de consulter les journaux d'audit depuis un tableau de bord unique.

Intégration Poussée avec Kubernetes

À l'ère des conteneurs, une intégration avec Kubernetes est essentielle. L'agent pourra être déployé en tant que "DaemonSet" pour s'exécuter sur chaque nœud du cluster. Il pourra interagir avec l'API Kubernetes pour optimiser le placement des pods, gérer automatiquement le scaling des déploiements en fonction de la charge, et analyser les logs des conteneurs pour détecter des anomalies.

Place de Marché de Modules Communautaires

Inspiré du succès du Hub de modèles, Hugging Face prévoit de lancer une place de marché pour les modules de l'agent. Les développeurs pourront créer et partager des modules spécifiques : un module pour gérer des bases de données PostgreSQL, un autre pour interagir avec l'API de Cloudflare, un troisième pour surveiller des applications Java. Cela créera un écosystème riche et dynamique autour de l'agent.

Devenez un Acteur de cette Révolution

L'avenir de l'administration système est en train de s'écrire, et il est open source. Hugging Face invite les développeurs, les administrateurs système et les passionnés d'IA du monde entier à participer. Que ce soit en signalant un bug, en améliorant la documentation, ou en développant un nouveau module, chaque contribution compte.

Contribuer sur GitHub